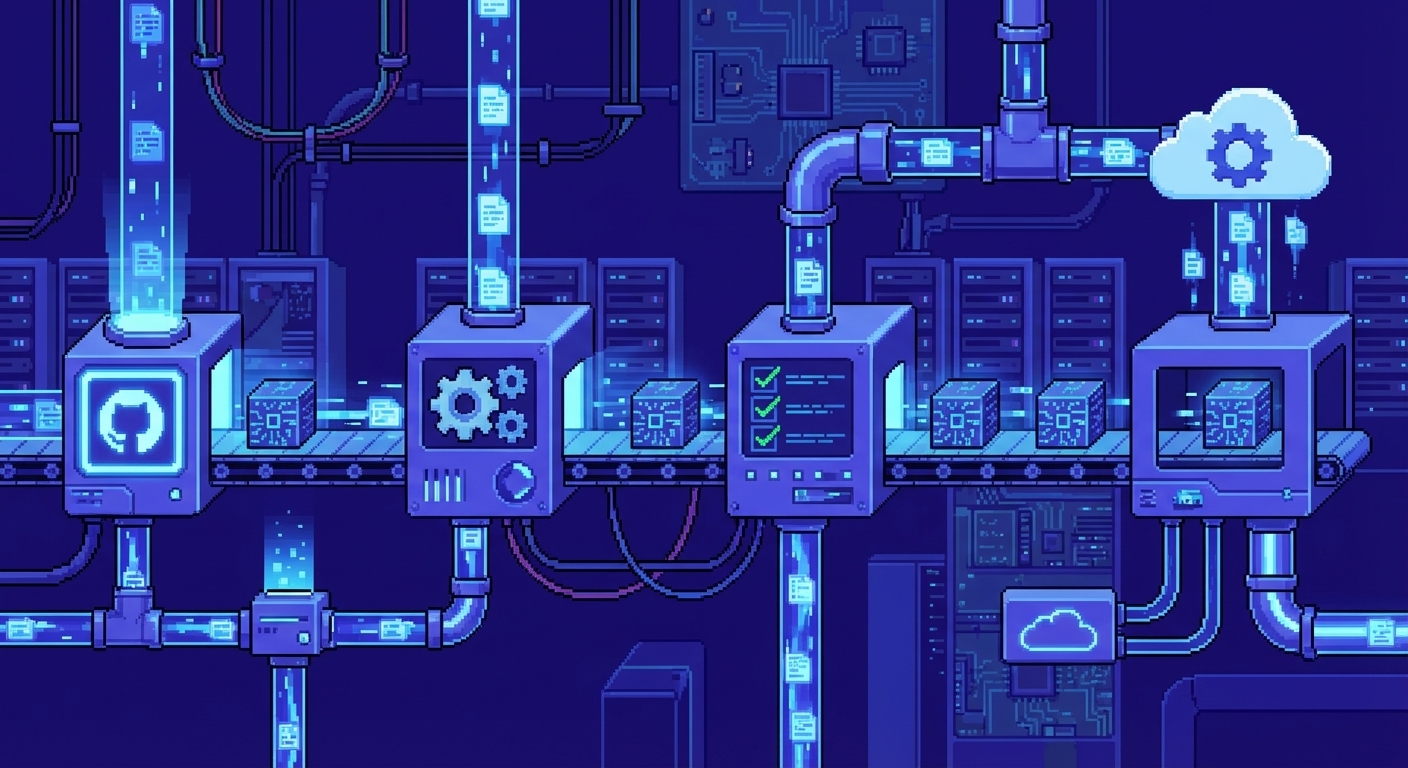

CI/CD : Intégration Continue & Livraison Continue

CI/CD : Intégration Continue & Livraison Continue

Origines et contexte historique

Avant les années 2000, on faisait du développement comme on construisait des cathédrales : on accumulait des modifications pendant des semaines, on travaillait en silos, et quand venait le moment de tout assembler, ça partait en vrille. Les intégrations massives tournaient au cauchemar : conflits impossibles à démêler, bugs qui se multipliaient comme des lapins, retards qui s'accumulaient. Plus tu détectais une erreur tard, plus elle coûtait cher à réparer. C'était l'époque où "ça marche sur ma machine" était une excuse valable.

L'intégration continue débarque dans les années 1990 avec l'Extreme Programming, portée notamment par Kent Beck. L'idée est simple mais radicale : au lieu d'attendre des semaines pour intégrer, tu le fais plusieurs fois par jour. Moins de conflits, un code qui reste stable, et surtout, des erreurs détectées tout de suite plutôt qu'à la veille de la release. Les tests automatisés deviennent le garde-fou : chaque modification doit passer le contrôle qualité avant d'être acceptée. C'est comme passer un contrôle technique à chaque fois que tu démarres ta voiture, sauf que là, ça a du sens.

Martin Fowler et ThoughtWorks ont théorisé et popularisé le truc. Puis Hudson, qui deviendra Jenkins, arrive au début des années 2000 et change la donne : l'intégration continue devient accessible, industrialisable, et l'industrie s'y met massivement. On passe du bricolage artisanal à l'automatisation à grande échelle.

Vers la livraison continue

La CI, c'est bien, mais ça ne règle qu'une partie du problème. L'intégration fonctionne, mais la livraison reste un truc manuel, stressant, réservé aux nuits de week-end et aux équipes qui ont le courage. Dans les années 2010, Jez Humble et David Farley sortent "Continuous Delivery" et posent les bases : le principe n'est pas de déployer automatiquement à chaque commit (ça, c'est le Continuous Deployment, on y viendra), mais de garantir que chaque build est prêt à partir en prod, n'importe quand, de façon fiable et reproductible. C'est comme avoir une voiture toujours prête à démarrer, même si tu ne la conduis pas tout de suite.

Cette capacité change tout. La livraison passe d'un événement exceptionnel, planifié des semaines à l'avance, à un processus banalisé, incrémental, sans risque majeur. Le Continuous Deployment pousse le concept encore plus loin : chaque changement validé part automatiquement en prod. C'est là que ça devient intéressant, ou terrifiant, selon ton niveau de confiance en tes tests.

Influence des géants du web et naissance du mouvement DevOps

Dans les années 2010, Flickr, Etsy, Facebook et autres géants du web commencent à partager publiquement leurs pratiques. Le message est clair : on peut déployer des centaines de fois par jour sans que tout parte en fumée. Au contraire, plus tu déploies souvent, plus c'est stable. C'est contre-intuitif, mais ça marche. Le mouvement DevOps émerge de cette réalité : fini les silos, place à la collaboration entre dev et ops, à l'automatisation systématique, et à la responsabilité partagée. Le "c'est pas mon problème" devient "c'est notre problème".

Le CI/CD devient le pilier de cette transformation. Il stabilise, accélère, sécurise. Il donne un feedback rapide, permet un apprentissage continu, et surtout, il crée une responsabilité partagée. Plus personne ne peut se cacher derrière "ça marchait en dev" ou "c'est la faute de l'infra". Tout est tracé, versionné, reproductible. C'est la fin de l'impunité technique.

L'ère du cloud, des conteneurs et des pipelines déclaratifs

Docker, Kubernetes et le cloud changent la donne. Les environnements deviennent reproductibles, standardisés, portables. Fini les "ça marche sur ma machine" et les environnements qui divergent entre dev, staging et prod. Les pipelines sont désormais du YAML, versionnés avec le code, exécutables partout. C'est la fin de l'époque où tu devais expliquer à un collègue comment installer Jenkins et configurer ses jobs à la main. Maintenant, tout est dans le repo, tout est déclaratif, tout est reproductible.

GitLab CI, GitHub Actions, Tekton, Argo Workflows, Woodpecker : cette nouvelle génération d'outils est cloud-native, déclarative, distribuée, orientée microservices et parfaitement intégrée à Git. Plus besoin de cliquer dans une interface web pour configurer tes jobs. Tout est code, tout est versionné, tout est tracé. C'est beau, non ?

Principes structurants du CI/CD

- Rien ne passe sans tests. Une modification n'est valide que si elle survit à la batterie de tests automatisés. Pas de négociation, pas d'exception, pas de "je le ferai plus tard".

- Tout est versionné. Les pipelines sont du code, ils vivent dans le repo, ils sont traçables et reproductibles. Plus de configuration perdue dans une interface web oubliée.

- Le feedback doit être rapide. Plus tu attends pour savoir si ton code casse, plus c'est dur de corriger. Un pipeline qui tourne pendant des heures, c'est un pipeline mal conçu.

- Tout ce qui est répétitif doit être automatisé. Les humains sont mauvais pour les tâches répétitives, les machines excellentes. Utilise-les.

- Les déploiements deviennent banals. Plus de stress, plus de nuits blanches, plus de "on déploie vendredi soir". C'est juste un processus normal, rapide et sûr.

Bénéfices

- Fini les intégrations qui tournent au cauchemar. Les erreurs sont détectées tout de suite, pas à la veille de la release.

- Les cycles de développement s'accélèrent. Tu peux itérer plus vite, tester plus souvent, déployer sans stress.

- La qualité du code s'améliore. Les tests deviennent une contrainte naturelle, pas un truc qu'on fait "si on a le temps".

- Les déploiements deviennent fréquents et fiables. Plus tu déploies souvent, moins c'est risqué. C'est mathématique.

- La collaboration s'améliore. Plus de silos, plus de "c'est pas mon problème". Tout le monde est responsable de tout.

- Tout est tracé. Tu sais qui a fait quoi, quand, pourquoi. Plus de mystères, plus de "ça a toujours été comme ça".

Limites et défis

- La mise en place initiale peut être complexe. Il faut choisir les bons outils, configurer les runners, mettre en place les tests. C'est du travail, et ça prend du temps.

- La maintenance, c'est un truc qu'on oublie souvent. Les pipelines vieillissent, les runners tombent en panne, les dépendances se mettent à jour. Il faut entretenir la bête.

- Il faut une stratégie de tests solide. Des tests qui tournent pendant des heures, des tests fragiles qui échouent aléatoirement, des tests qui ne testent rien : tout ça, ça tue le CI/CD.

- L'intégration avec des systèmes legacy, c'est la croix et la bannière. Les vieux systèmes ne sont pas faits pour ça, et les adapter coûte cher.

- Les pipelines mal conçus sont un piège. Trop longs, trop fragiles, trop complexes : ils finissent par devenir un frein plutôt qu'un accélérateur.

Le CI/CD demande de la rigueur, une maturité technique, et surtout une culture d'équipe qui accepte l'amélioration continue. Si ton équipe préfère le statu quo et les excuses, passe ton chemin.

Références fondatrices

- Martin Fowler, 'Continuous Integration'

- Jez Humble & David Farley, 'Continuous Delivery'

- Nicole Forsgren, Jez Humble & Gene Kim, 'Accelerate'

- Gene Kim et al., 'The DevOps Handbook'

📄️ Act

Alternative locale à GitHub Actions permettant d'exécuter des workflows GitHub Actions localement sans push vers GitHub.

📄️ Argo Workflows

Argo Workflows est un orchestrateur de workflows natif Kubernetes, déclaratif et basé sur des Custom Resource Definitions (CRD).

📄️ Concourse CI

Concourse CI est un moteur CI/CD moderne, déclaratif et cloud-native, basé sur des pipelines immutables et des ressources réutilisables.

📄️ Drone CI

Drone CI est un moteur CI/CD moderne, cloud-native et conteneurisé, basé sur un fichier YAML versionné.

📄️ GoCD

GoCD est un moteur CI/CD mature, open-source, spécialisé dans la livraison continue avec une approche basée sur les pipelines de valeur.

📄️ GitLab CI

GitLab CI/CD est un moteur CI/CD moderne, déclaratif et intégré au SCM, basé sur un fichier YAML versionné.

📄️ Jenkins

Jenkins est un serveur CI/CD open-source extrêmement extensible, basé sur un système de jobs et de pipelines déclaratifs.

📄️ Komodo

Komodo est un système de build et de déploiement open-source, spécialisé dans la construction automatique d'images Docker et le déploiement de conteneurs sur plusieurs serveurs.

📄️ OneDev

Plateforme DevOps complète auto-hébergeable avec Git, CI/CD, issues, et pull requests intégrés, alternative open-source à GitLab.

📄️ Screwdriver CD

Screwdriver CD est un moteur CI/CD moderne, open-source et microservices-based, développé par Yahoo, optimisé pour la conteneurisation.

📄️ Tekton

Tekton est un framework CI/CD cloud-native standardisé, déclaratif et basé sur des Custom Resource Definitions (CRD) Kubernetes.

📄️ Woodpecker CI

Woodpecker CI est un moteur CI/CD moderne, léger et entièrement open-source, basé sur un fichier YAML versionné.

📄️ Zuul

Zuul est un moteur CI/CD open-source développé par l'OpenStack, spécialisé dans la gestion de projets à grande échelle avec gating des changements.